Twój koszyk jest obecnie pusty!

Jak uruchomić własny ChatGPT z AutoGPT?

Wzrastające zainteresowanie ChatGPT skłoniło wiele osób do zastanowienia się, jak mogą wykorzystać jego potencjał do automatyzacji lub usprawnienia swojej pracy. Wielu z nas marzy o tym, aby ChatGPT zajął się żmudnymi zadaniami, które często pochłaniają nasz cenny czas. Z takiego właśnie podejścia narodził się projekt open source – AutoGPT, zapoczątkowany przez Torana Bruce Richardsa, znanego również jako Torantulino.

AutoGPT to innowacyjny projekt, który bazuje na możliwościach ChatGPT. Jego głównym celem jest stworzenie w pełni autonomicznego asystenta AI, dostępnego dla każdego. Asystent ten ma możliwość wykonywania najróżniejszych zadań – od przeglądania internetu, przez zamawianie pizzy, aż po pisanie artykułów czy kodowanie. Projekt ten zyskał ogromną popularność w krótkim czasie, zdobywając jako drugi projekt open source związany z AI aż 100 tysięcy gwiazdek na GitHubie.

To dopiero początek

Mimo iż projekt cieszył się ogromną popularnością od samego początku, można śmiało stwierdzić, że dopiero nabiera tempa. Twórcy AutoGPT zgromadzili wokół siebie aktywną społeczność, liczącą niemal 300 osób, które codziennie pracują nad wprowadzaniem nowych funkcjonalności.

Na chwilę obecną, AutoGPT dostępny jest jedynie poprzez linię komend, jednak zespół nieustannie pracuje nad stworzeniem interfejsu graficznego. Taki interfejs pozwoli na korzystanie z aplikacji bez konieczności posiadania umiejętności programowania. Gdy tylko interfejs graficzny (GUI) zostanie udostępniony, na pewno poinformujemy o tym na naszym blogu. Dlatego zachęcamy do regularnego odwiedzania naszej strony, aby być na bieżąco z najnowszymi aktualizacjami.

Dodatkowo, w najnowszej wersji v0.2.2 udostępniony po raz pierwszy został mechanizm pluginów, który pozwala znacznie poszerzać możliwości wykorzystania AutoGPT. Dzięki pluginom, można połączyć model z zewnętrznymi systemami, aby osiągnąć jeszcze wyższy poziom automatyzacji. Możemy na przykład połączyć model z naszą skrzynką e-mail, aby przygotowywała szkice odpowiedzi na maile, połączyć z kontem Twitterowym, aby automatycznie tworzyć twitty. Podobnie możemy połączyć AutoGPT z YouTubem czy Facebookiem i innymi serwisami. Cały katalog dostępnych pluginów można zobaczyć tutaj: https://autoplugins.vercel.app

Przygotowanie klucza do instalacji AutoGPT

Aby skorzystać z AutoGPT, konieczne jest posiadanie płatnego konta w ChatGPT od Open AI. Jeżeli jeszcze nie posiadasz takiego konta, możesz je założyć, korzystając z tego linku: https://platform.openai.com/signup.

Po utworzeniu konta, konieczne jest zmiana jego rodzaju na „płatne” oraz dodanie danych karty płatniczej.

Płynne korzystanie z AutoGPT wymaga posiadania płatnego konta w ChatGPT, ponieważ umożliwia to wygenerowanie klucza niezbędnego do połączenia obu systemów. Można go utworzyć na stronie: https://platform.openai.com/account/api-keys. Klucz stanowi ważny element, umożliwiający pełne wykorzystanie możliwości AutoGPT. Wykorzystamy go podczas konfiguracji AutoGPT. Pamiętaj, aby nikomu nie udostępniać klucza, ponieważ jego utrata może narazić Ciebie na spore koszty, jeśli ktoś inny zdecyduje się go wykorzystać.

Uwaga! Sugerujemy regularne sprawdzanie kosztów wykorzystania API ChatGPT.

Przejdźmy do czynów, czyli instalacja AutoGPT

AutoGPT może zostać uruchomiony na 3 sposoby:

- za pomocą Dockera

- w środowisku Python 3.10 lub późniejszym

- za pomocą VSCode + devcontainer

W tym artykule zajmiemy się instalacją AutoGPT z pomocą Dockera, ponieważ jest to rekomendowana i według mnie, najszybsza metoda instalacji. Jeśli nie masz doświadczenia w pracy z Dockerem, daj znać w komentarzach, a napewno pomożemy. W dalszej części zakładam, że posiadasz zainstalowany i uruchomiony na swoim komputerze Docker.

Najpierw pobieramy obraz dockerowy, za pomocą komendy:

docker pull significantgravitas/auto-gptNastępnie utwórzmy katalog, w którym zapiszemy plik docker-compose.yml

mkdir myautogpt

cd myautogpt

touch docker-compose.ymlOtwórz utworzony plik docker-compose.yml i wprowadź do niego treść:

version: "3.9"

services:

auto-gpt:

image: significantgravitas/auto-gpt

depends_on:

- redis

env_file:

- .env

environment:

MEMORY_BACKEND: ${MEMORY_BACKEND:-redis}

REDIS_HOST: ${REDIS_HOST:-redis}

profiles: ["exclude-from-up"]

volumes:

- ./auto_gpt_workspace:/app/autogpt/auto_gpt_workspace

- ./data:/app/data

## allow auto-gpt to write logs to disk

- ./logs:/app/logs

## uncomment following lines if you have / want to make use of these files

#- ./azure.yaml:/app/azure.yaml

#- ./ai_settings.yaml:/app/ai_settings.yaml

redis:

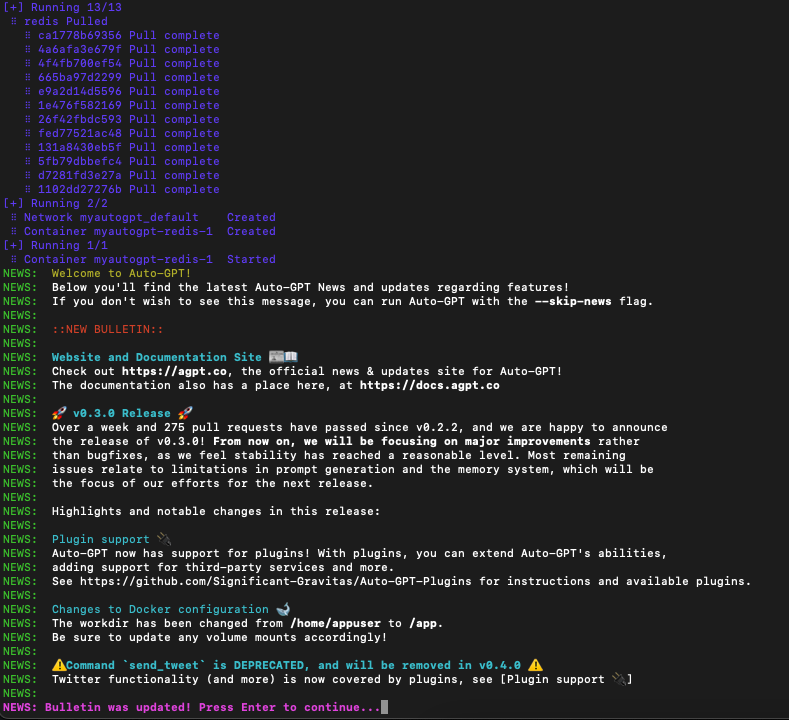

image: "redis/redis-stack-server:latest"W ramach środowiska dockerowego uruchomione zostaną dwie usługi: baza danych Redis oraz aplikacja AutoGPT. Aplikacja potrzebuje dodatkowych zmiennych konfiguracyjnych, aby mogła poprawnie działać, dlatego należy utworzyć plik o nazwie: .env, w którym wprowadzamy następującą treść:

OPENAI_API_KEY=your-openai-api-keyW treści należy podmienić text your-openai-api-key na wartość klucza OpenAI, który generowaliśmy przed rozpoczęciem instalacji AutoGPT. Zmiennych konfiguracyjnych może być znacznie więcej, ale nie będziemy ich poruszać w tym artykule. Szablon pliku .env z informacjami o innych zmiennych konfiguracyjnych można znaleźć bezpośrednio w repozytorium AutoGPT, pod adresem: https://github.com/Significant-Gravitas/Auto-GPT/blob/master/.env.template

Uruchamiamy AutoGPT!

Aby uruchomić aplikację, wykonujemy komendę:

docker-compose run --rm auto-gpt

Voila! Po poprawnym uruchomieniu usług dockerowych, możemy skorzystać z aplikacji i zlecić pierwsze zadanie naszemu asystentowi AI.